渤小海伴您读研报之工业富联

(转自:渤海证券财富管理)

1.公司概况

1.1持续强化高端智能制造,前瞻性布局迎来AI风口

工业富联是全球领先的高端智能制造及工业互联网解决方案服务商。自2018年上市以来,公司依托于数字经济新基建的发展机遇,在持续强化“高端智能制造+工业互联网”这一核心竞争力的基础上,加速推进“2+2”战略,围绕“大数据”和“机器人”,进一步拓宽业务版图。公司的主要业务包括通信及移动网络设备、云计算、工业互联网。公司基于超过30年的高端智能制造行业数据经验,大力推动ICT全产业链的数字化转型,已发展成为全球数字经济领军企业,在产品、技术以及全球市占率方面处于领先地位。

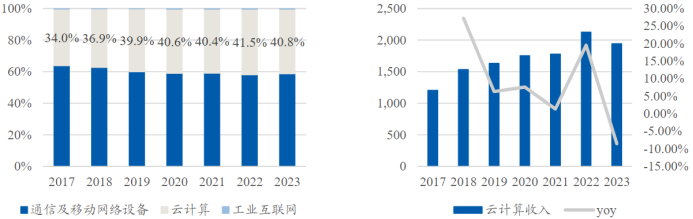

1.2AI服务器需求强劲,云计算营收持续增长

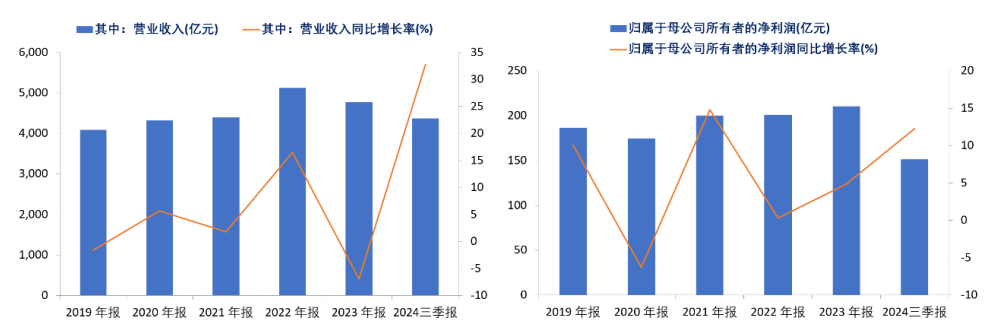

公司在24年前三季度实现收入4364亿,同比增长33%;归母净利润151亿,同比增长12%。2024年前三季度,公司云计算业务收入同比增长71%,其中,AI服务器收入同比增长228%,占整体服务器营收比重提升至45%。单季AI服务器占整体服务器营业收入比重,从Q2的46%提升至Q3的48%,占比持续逐季提升。通用服务器出货亦持续回温,2024年前三季度营业收入同比增长22%;云服务商2024年前三季度营业收入同比增长76%,营收占比为46%。

公司收入规模、增速变化及公司归母净利润及增速变化

2.AI服务器行业概况

2.1资源向云厂商集中,AI服务器打开长期成长空间

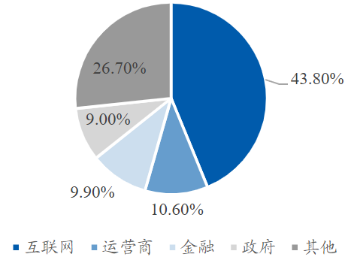

云厂商开启大模型军备竞赛,AI服务器需求量大幅抬升。根据TrendForce,预估2023年AI服务器(包含搭载GPU、FPGA、ASIC等)出货量近120万台,年增38.4%,占整体服务器出货量近9%,预计2024年AI服务器出货量同比增速将达到42%,2025年受云端业者及主权云等需求带动,出货量有望再增长约28%,推动AI服务器占整体服务器市场出货量比例提高至近15%。从行业的角度看,互联网依然是最大的采购行业,占整体加速服务器市场近60%的份额,此外金融、电信、交通和医疗健康等多数行业均有超过一倍以上的增长。从互联网角度看,为了训练自己的AI大模型,在下一代技术变革中取得先发优势,各大厂对于AI投入的重视程度显著提升,并开启一轮AI算力储备。

2022年国内服务器下游行业分布

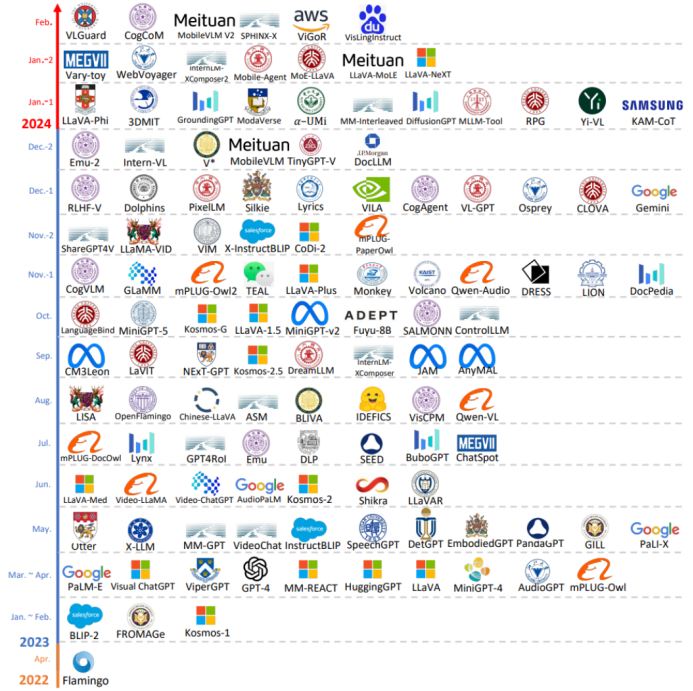

训练侧:大模型支持更多模态,参数规模扩展增加算力需求。随着多模态模型GPT-4(Vision)和Gemini的首次亮相,多模态模型的研究从早期的多模态理解主机按过渡到多模态内容生成。当前多模态大语言模型采用并联式框架,多模态数据送到各自模态的编码器后转换为大语言模型的文本编码,再由大语言模型处理后,经过特定模态的转换器后输出。未来的多模态模型可能会促进多模态融合,即在不同数据模态之间实现无缝的信息共享和转换,构建通用表征空间,使文本、图像、音频等模态的信息在共享空间中自由传递和相互影响,从而增强理解和生成能力。整合不同模态信息的复杂结构可能会导致参数量、模型的层数、计算单元显著增加,多模态也将带来数据量需求的提升,从而导致训练侧算力需求扩大。

多模态大模型时间轴

资料来源:《MM-LLMs:Recent Advances in Multi Modal Large Language Models》

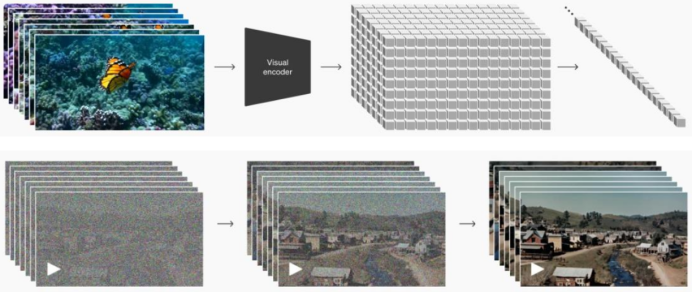

推理侧:视频生成、推理优化模型带动推理侧算力需求指数级增长。目前最新发布的视频生成模型大多数为DiT模型,相较于前一代Video Diffusion Model和大语言模型,除本身参数量增长外,模型不仅要按帧生成图片,还需要引入时间这一维度,捕捉帧间关系,从而增加了推理的计算量。而OpenAI在2024年9月发布的o1模型则将Scaling Law扩展至推理,在推理过程中引入思维链(CoT,Chain of Thought),将输入问题拆解为多个逻辑步骤,每增加一个步骤,推理计算量成倍增加。参考OpenAI对于o1模型的定价,逻辑推理类模型的推理算力消耗至少为同等参数量大语言模型的3-4倍。

Sora视频生成模型DiT架构原理

2.2高端AI服务器形态发生变化,产业链得到重塑

训练端产业链由英伟达主导,推理端百花齐放。根据TrendForce,从AI服务器搭配AI芯片类型来看,预计2024年主流搭载GPU的AI服务器占比为71%,其中英伟达凭借H200产品,市占率逼近9成,AMD市占率约为8%;CSPs自研ASIC服务器出货量占整体AI服务器的比重有望达到26%。而展望2025年,市场对于高阶AI服务器需求仍强,尤其以英伟达新一代Blackwell将取代Hopper平台成为市场主流,且出货形式有望从8卡HGX服务器向机柜转移。

预计机柜级产品将成为明年Blackwell架构产品出货的主要形式。鸿海发言人曾在法说会上回应,预计今年第四季度小量生产GB200服务器,2025年大量出货。鸿海年度科技日上,董事长刘扬伟表示市场对Blackwell芯片的需求达到“疯狂程度”,计划到2025年产能达到20000台英伟达NVL72机柜。GB200超级芯片将CPU和GPU都位于同一块PCB板上,降低了插入损耗,提升了CPU和GPU之间的通讯能力;GB200NVL72引入了尖端功能和第二代Transformer引擎,支持FP4AI,与第五代NVIDIA NVLink结合使用时,可为万亿参数语言模型提供30倍的实时LLM推理性能;与NVIDIA H100风冷基础设施相比,GB200在相同功率下可以提供25倍的性能。因此对于Blackwell架构,GB200机柜级产品在算力、连接、功耗方面较8GPUHGX服务器更具有性价比,将成为未来的主要出货形式。

3.公司竞争优势

3.1服务器ODM核心参与者,受益于CSP定制化需求增长

工业富联云计算业务包含服务器、存储设备、云服务设备高精密结构件。公司服务器领域已实现前端到后端的全产业链覆盖,服务器业务的主要客户为品牌服务器厂商(如Dell、HPE)和云服务提供商(CSP,如Amazon),品牌服务商提供服务器及相关解决方案给到终端企业及政府单位、电信运营商、有线电视运营商等。

公司云计算业务受AI拉动已呈现出高速增长态势,占整体收入比例提升。2023年公司云计算实现营业收入1943.07亿元,占整体营收的比重为40.79%,为公司第二大业务。2024年前三季度,云计算收入同比增长71%,其中云服务商收入同比增长76%,占比46%;AI服务器占整体服务器营收比重提升至45%,收入同比增长228%。2024Q3,公司AI服务器占整体服务器营业收入比重提升至48%,占比逐季提升。通用服务器板块也持续回温,2024年前三季度营业收入同比增长22%。

工业富联分项业务收入占比(%)及工业富联云计算业务营业收入、增速(亿元/%)

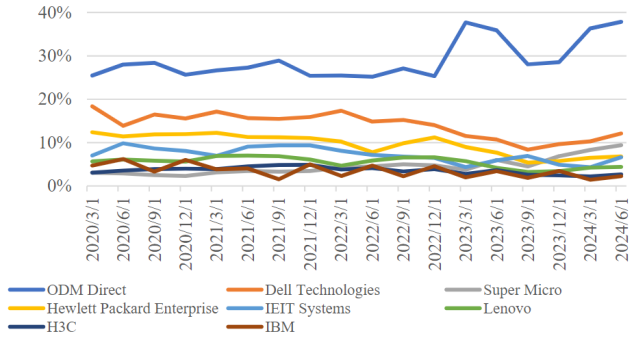

ODM Direct服务器市场份额持续提升,云计算为白牌服务器带来发展机遇。根据Bloomberg数据,截至2024Q2,全球服务器市场规模达到542亿美元,其中ODM direct市占率连年提升,由2020年初的25.5%提升至38%;根据Counterpoint,2021年ODM Direct实现收入302亿美元,其中富士康实现收入126亿美元,占比达到41.8%。云计算产业的发展使得服务器采购向头部云厂商集中,而云厂商为了体现技术、服务的差异,普遍采购定制化服务器,直接向ODM厂商下单,由ODM根据要求提供代工、组装服务后出货给云厂商。工业富联涉及服务器生产的L1-L12所有环节,同时公司以往积累的供应链基础使公司具备较强成本控制能力和交付能力,能够更好地满足CSP的定制化需求,提升CSP客户的性价比。

服务器市占率(%)

3.2公司与英伟达密切合作,有望提升机柜级方案中的价值量

公司在AI服务器业务中保持了与英伟达的密切合作。公司与英伟达的合作可追溯至2017年,深度参与了英伟达首台AI服务器的前期研发和产品设计。在英伟达近期推出的AI服务器供应链中,工业富联是A100/H100/B100/B200板卡的独家代工供应商;在GPU基板方面,公司也占据了较高的市场份额。公司还参与了HGX服务器的母版、服务器整机、机柜等制造环节,并出货给品牌服务商和云厂商。

在GB200机柜的生产制造环节中,公司参与的环节显著增加,份额有所提升。公司DGX模式的标准化机柜实际客户为英伟达,而MGX模式也需要将计算托盘、交换托盘制造好后交付英伟达,CSP客户于英伟达方面采购这些模块后,加入定制化设计,并交由ODM厂商生产。基于英伟达和公司持续的密切合作关系,公司能够深入参与到DGX模式和MGX模式的代工中,份额及ASP均显著提升。此外,10月8日,富士康母公司鸿海宣称公司正在墨西哥建设全球最大的英伟达GB200制造厂,以帮助缓解外界对英伟达Blackwell平台的巨大需求;董事长刘扬伟强调,鸿海的供应链已经准备好,包括垂直整合的制造能力、还包括支持GB200服务器基础设施所需的先进冷液和散热技术。新工厂的设立有望持续扩大GB200产能,强化供应链稳定性。

编发| 邢艳

复审| 张宏魁

审核| 李皓